In der heutigen Geschäftswelt sind Unternehmen bei der Entscheidungsfindung auf robuste Datenpipelines angewiesen. Angesichts des zunehmenden Volumens und der Komplexität der Daten ist die Gewährleistung ihrer Zuverlässigkeit jedoch eine große Herausforderung.

An dieser Stelle wird die Beobachtbarkeit von Daten entscheidend. Diese Disziplin ermöglicht die Überwachung und das Verständnis von Datenflüssen und bietet volle Transparenz über deren Qualität, Fluss und Leistung.

Auf diese Weise können die Teams Probleme proaktiv erkennen und beheben, was zu einem zuverlässigeren und effizienteren Datenbetrieb führt.

Einführung in die Beobachtbarkeit von Daten

Daten sind zur treibenden Kraft für Innovationen und Unternehmensentscheidungen geworden, was die Beobachtbarkeit von Daten zu einer entscheidenden Disziplin macht. Dies stellt eine notwendige Entwicklung in der Art und Weise dar, wie Unternehmen ihre Daten verwalten und nutzen.

Im Kern ist Data Observability die Fähigkeit, den Zustand, die Gesundheit und die Leistung von Daten während ihres gesamten Lebenszyklus zu verstehen. Dazu gehört ein umfassender und kontinuierlicher Einblick in Datenpipelines, -quellen, -transformationen und -nutzung, der es uns ermöglicht, Datenprobleme proaktiv zu erkennen und zu lösen, bevor sie sich negativ auswirken.

Data Observability konzentriert sich auf spezifische Datenmetriken, einschließlich:

- Frische: Wann wurden die Daten zuletzt aktualisiert und kommen sie rechtzeitig und mit der erwarteten Regelmäßigkeit an?

- Volumen:Entspricht die Menge der eingehenden oder ausgehenden Daten den Erwartungen, gibt es anormale Spitzen oder Rückgänge?

- Schema:Hat sich die Datenstruktur unerwartet verändert, wurden Spalten hinzugefügt, gelöscht oder geändert?

- Qualität:Sind die Daten genau, vollständig, konsistent und gültig, und gibt es Nullen, Duplikate oder Werte außerhalb des zulässigen Bereichs?

- Abstammung:Woher stammen die Daten, wie wurden sie umgewandelt und von welchen Systemen oder Nutzern werden sie verwendet?

Durch die Überwachung dieser fünf Säulen können sich Organisationen ein klares Echtzeitbild von der Zuverlässigkeit ihrer Daten verschaffen, Risiken mindern und sicherstellen, dass die Informationen für die Entscheidungsfindung und auf zuverlässige Weise verwendet werden.

Analysesoftware: Rückgrat der Datenbeobachtung

Eine Datenanalysesoftware ist ein Muss für eine effektive Datenbeobachtung. Sie ist keine Option, sondern eine Notwendigkeit in der heutigen komplexen Datenlandschaft, die es Unternehmen ermöglicht, vom reaktiven zum proaktiven und strategischen Datenmanagement überzugehen.

Die wichtigsten Gründe sind:

- Erkennung von Anomalien in Echtzeit: Software, die oft auf KI und maschinellem Lernen basiert, geht über statische Schwellenwerte hinaus, lernt normale Muster und erkennt subtile Anomalien in Bezug auf Datenvolumen, Aktualität oder Verteilung, die sonst unbemerkt bleiben würden.

- Umfassende und zentralisierte Sichtbarkeit: Bietet einheitliche Dashboards und Visualisierungen, die den Datenzustand konsolidieren. Dadurch erhalten die Teams einen 360-Grad-Blick auf die Beobachtbarkeit der gesamten Datenpipeline, wodurch blinde Flecken vermieden werden.

- Automatisierung und Effizienz:Automatisiert die Erfassung von Metriken, die Ausführung von Qualitätsregeln und die Erkennung von Anomalien. Dadurch wird der manuelle Aufwand reduziert, wodurch Ingenieure und Analysten für höherwertige Aufgaben frei werden und proaktive Warnungen für eine schnelle Lösung ermöglicht werden.

- Rationalisierung der Ursachenforschung: Analyseplattformen korrelieren Metriken und Ereignisse und liefern so einen umfassenden Kontext für Probleme. Sie können den Verlauf betroffener Daten, fehlgeschlagener Umwandlungen und betroffener Berichte aufzeigen und so die Problemlösung optimieren.

- Kontinuierliche Qualitätsverbesserung:Die Software identifiziert wiederkehrende Muster von Datenfehlern und ermöglicht es Unternehmen, systemische Ursachen zu beseitigen und sicherzustellen, dass neue Änderungen keine Qualitätsprobleme verursachen.

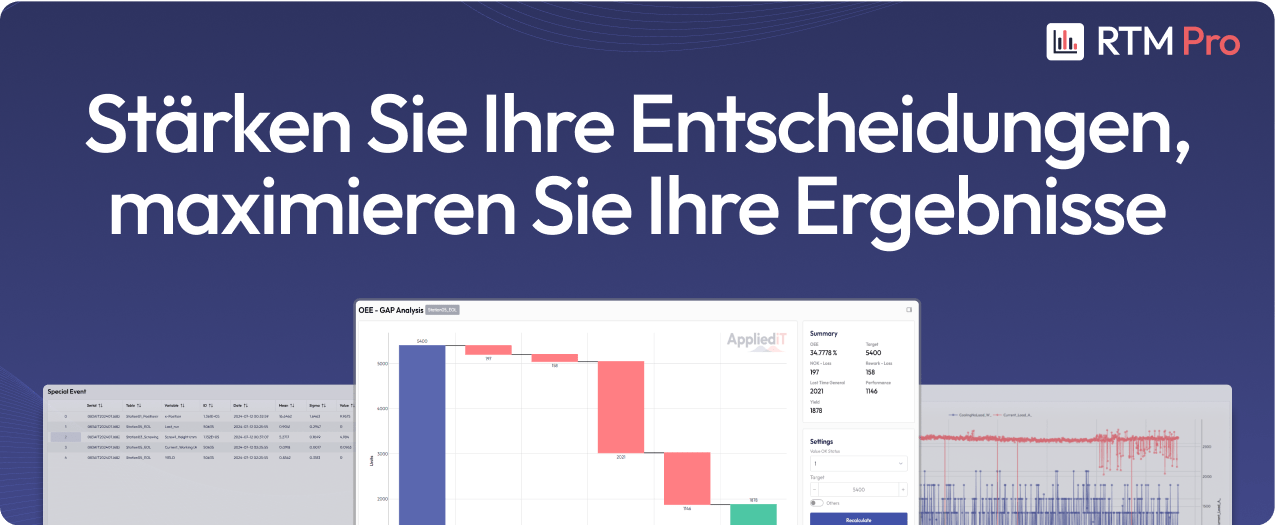

Die Anwendung einer Lösung wie RTM Pro kann von großem Wert sein, da sie speziell für die Problemlösung in der Fertigungs- und Industrie 4.0-Umgebung konzipiert ist. Die Fähigkeit von RTM Pro, Daten in Echtzeit zu analysieren, ist von grundlegender Bedeutung für die Datenbeobachtung, insbesondere im Betrieb.

Darüber hinaus liegt ihr Wert in der Ermittlung von Trends, Korrelationen, Schlüsselindikatoren und den Ursachen von Problemen.

Vorteile der Beobachtbarkeit von Daten

Die Umsetzung einer robusten Strategie zur Datenbeobachtung ist nicht nur eine Vorsichtsmaßnahme, sondern eine Investition, die mehrere entscheidende Vorteile mit sich bringt und die Art und Weise verändert, wie Unternehmen mit ihrem wertvollsten Kapital umgehen. Aber das ist noch nicht alles. Sie bietet auch Vorteile, die von entscheidender Bedeutung sind:

- Vertrauen in Daten: Stellt sicher, dass die Daten genau und aktuell sind und ermöglicht so schnelle und zuverlässige Entscheidungen.

- Proaktive Erkennung und Geschwindigkeit:Identifiziert Datenprobleme in Echtzeit und verkürzt die Zeit zur Erkennung und Behebung von Problemen (MTTD/MTTR), bevor sie sich auswirken.

- Operative Effizienz: Die Überwachung wird automatisiert, so dass sich die Datenteams nicht mehr mit der „Brandbekämpfung“ beschäftigen müssen, sondern sich auf höherwertige Aufgaben konzentrieren können.

- Kontinuierliche Qualitätsverbesserung:Ständiges Feedback zur Qualität, so dass die Ursachen von Problemen systematisch angegangen werden können.

- Befähigung der Benutzer:Durch die Stärkung des Vertrauens in Daten wird der Zugang zu ihnen und ihre Nutzung durch die Unternehmensteams demokratisiert.

- Robuste AI/ML-Unterstützung: Gewährleistet, dass KI- und Machine Learning-Modelle mit zuverlässigen und aktuellen Daten arbeiten, die für ihre Genauigkeit und ihren Wert entscheidend sind.

Conclusion

In der dynamischen Unternehmenslandschaft des Jahres 2025, in der Daten das wertvollste Gut sind und sich die künstliche Intelligenz als eine Säule der Innovation etabliert, ist Datenbeobachtung nicht länger ein Ziel, sondern ein strategischer Imperativ. Es reicht nicht mehr aus, große Mengen an Informationen zu sammeln und zu speichern. Der wahre Wettbewerbsvorteil liegt in der Fähigkeit, sich in jeder Phase des Lebenszyklus auf diese Daten verlassen zu können.

Die Implementierung einer robusten Strategie zur Datenbeobachtung gewährleistet, dass Unternehmen proaktiv die Aktualität, das Volumen, das Schema, die Qualität und die Herkunft ihrer Daten überwachen können. Dieser umfassende Ansatz ermöglicht die frühzeitige Erkennung von Anomalien, wodurch Ausfallzeiten und die negativen Auswirkungen auf wichtige Abläufe und die Entscheidungsfindung drastisch minimiert werden. Durch den Wechsel von reaktivem zu proaktivem Management befreien Unternehmen ihre wertvollen Datenteams von „Feuerwehraufgaben“ und können sich so auf Innovation und Wertschöpfung konzentrieren.

Über die betriebliche Effizienz hinaus schafft Data Observability eine Kultur des Vertrauens in die Daten im gesamten Unternehmen, stärkt die Geschäftsanwender und stellt sicher, dass KI- und Machine Learning-Initiativen auf einer soliden und zuverlässigen Informationsgrundlage beruhen. Letztendlich ist eine Investition in Data Observability eine Investition in die Widerstandsfähigkeit, Agilität und Entscheidungsfähigkeit des Unternehmens – entscheidende Pfeiler für eine erfolgreiche Navigation in die Zukunft.

Teile diesen Beitrag